[한국대학신문 이정환 기자] 한양대학교(총장 이기정) 융합전자공학과 최정욱 교수 연구팀이 대규모 언어 모델 추론 비용을 줄일 수 있도록 심층 신경망 연산을 저정밀도에서 수행하면서 성능 하락이 없도록 하는 데이터 표현 방식과 알고리즘을 개발했다고 한양대가 28일 밝혔다.

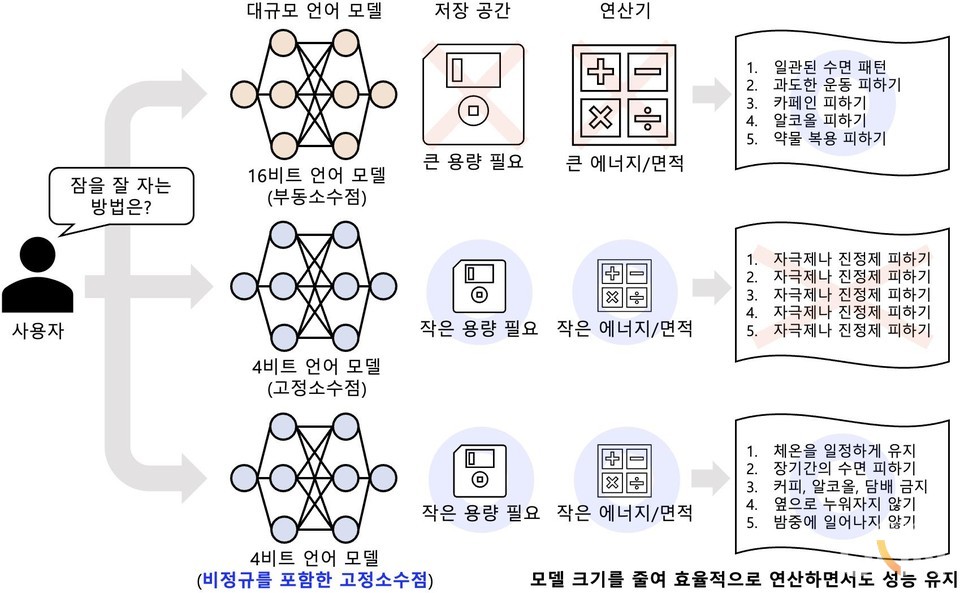

대규모 언어 모델은 심층 신경망의 가중치 수를 크게 늘리면서 사람을 뛰어넘는 성능을 달성하는데, 일반적으로 심층 신경망 내에서 16비트 부동소수점으로 모델 가중치와 활성화를 연산하기 때문에 언어 문장을 생성할 때 막대한 저장 공간이 필요하고 연산 비용이 발생한다는 단점이 있다. 연산하는 데이터의 정밀도를 16비트보다 낮추면 저장 공간과 연산 비용을 줄일 수 있으나, 모델의 추론 성능이 크게 떨어지게 된다.

이러한 단점을 극복하기 위해, 별도의 추가 훈련 없이 연산하는 데이터의 정밀도를 낮추면서도 언어 모델의 성능을 유지하는 학습 후 양자화 기법 (post-training quantization)이 큰 주목을 받고 있다. 기존의 학습 후 양자화 기법은 가중치와 활성화를 모두 8비트로 양자화하거나, 모델의 가중치만 4비트로 양자화하고 활성화는 16비트로 두어 여전히 16비트 연산기를 필요로 하고 있다. 활성화를 8비트로 양자화 하면서 가중치를 8비트보다 더 낮은 정밀도로 양자화해 저장 공간과 연산기의 효율 모두를 극대화하는 연구는 덜 탐구돼 온 영역이다.

최정욱 교수팀이 개발한 기술은 언어 모델의 활성화를 8비트로 표현하면서도, 가중치를 4비트로 크게 낮춰 저장 공간뿐 아니라 연산기의 에너지와 면적을 모두 크게 낮추는 기술이다. 연구팀은 대규모 언어 모델의 가중치를 매우 낮은 정밀도로 표현할 때 기존의 고정소수점을 사용하는 대신, 부동소수점에서 사용되는 비정규 표현을 고정소수점에 함께 사용했을 때 언어 모델이 단어를 잘못 생성하는 것을 크게 막을 수 있다고 전했다.

최정욱 교수 연구팀은 저 정밀도 추론에서 값이 0으로 양자화되는 현상이 성능에 큰 영향을 미침을 발견하고, 이를 해결하기 위해 0 근처의 비정규 특이값을 따로 지정해 처리가 가능하도록 했다.

연구팀은 제안하는 데이터 표현 방식의 연산기를 7나노미터 공정으로 합성해 하드웨어적인 이점을 평가했으며, 8비트 연산기보다도 두 배의 에너지 및 면적 효율을 가지면서도 성능 하락을 막을 수 있어 실용적이라고 전했다.

또한 언어 생성 문제에서 품질 저하를 평가한 결과 4비트 가중치와 8비트 활성화로도 언어 모델이 만드는 단어의 당혹감(perplexity)이 16비트 추론에 비해서 거의 증가하지 않음을 보였다.

더불어 간단한 질의응답부터 법, 물리, 화학 등의 수학 문제가 포함된 성능 평가에서도 정답률이 16비트 추론 대비 거의 하락하지 않았다고 전했다. 연구팀은 1억 개부터 650억 개의 가중치를 가진 다양한 대규모 언어 모델들에 대해서 이러한 성능 평가를 진행했으며, 650억 개의 가중치를 가진 대규모 언어 모델의 경우에도 제안하는 방법론이 잘 동작함을 보였다.

공동 1저자인 한양대 일반대학원 융합전자공학과에 재학 중인 이장환, 김민수 박사과정 학생과 AI 반도체 기업 사피온 코리아, 서울대 성원용 교수가 함께 참여한 이번 연구는 세계 권위의 자연어처리 학회인 EMNLP 2023에서 12월 발표될 예정이다.